|

Ar@cne |

RANKINGS

MUNDIALES DE UNIVERSIDADES:

OBJETIVOS Y CALIDAD

Karsten Krüger

Fundación

Bosch i Gimpere

Universidad de Barcelona

<kkruger@fbg.ub.es>

Alba Molas

Alba

e.V.

<albamolas@yahoo.de>

Rankings mundiales de universidades: objetivos y calidad (Resumen).

En todos los ámbitos educativos e investigadores, se ha puesto de moda elaborar rankings (o clasificaciones ordenadas) evaluando y comparando la calidad de las instituciones o de los sistemas. También en el ámbito universitario han proliferado en la última década rankings tanto a escala mundial como a escala nacional debido: a) a la globalización de la competición entre universidades dentro del contexto de la sociedad del conocimiento globalizado; b) a la creciente demanda de información comparable por parte de los ‘clientes’ (por ejemplo, los estudiantes y sus familias); c) la creciente demanda por parte de los gobiernos y de la sociedad a una mayor responsabilidad de la universidades frente a la sociedad, lo cual se traduce en mayores exigencias de calidad de los servicios prestados a la sociedad.

Este artículo presenta los resultados de una búsqueda de rankings en Internet y de su trasfondo metodológico. El objetivo es: a) presentar diferentes rankings, b) analizar sus objetivos y metodología, y c) efectuar un crítica constructiva. Éste es el primero de dos artículos dedicado solamente a rankings internacionales, mientras que el segundo se centrará en las clasificaciones de las universidades españolas. El núcleo del artículo es la presentación de diez rankings internacionales en forma de fichas para facilitar al lector una información resumida; además, se divide en 4 capítulos: objetivo, metodología, presentación y comentarios. En el apartado final, comparamos los diferentes rankings y discutimos su validez haciendo referencia también a artículos disponibles en línea y de acceso libre referente al tema.

El artículo resalta la importancia de los rankings como instrumentos de la política educativa y científica global aportando, sin embargo, una visión crítica a los rankings, reconociendo, al mismo tiempo, que pueden tener una función importante para mejorar las actuaciones de las universidades siempre y cuando anuncian bien: los objetivos de los rankings, el tipo de universidad a que se refieren, el ámbito concreto de la evaluación, la metodología utilizada y que permitan realmente introducir mejoras en las universidades al nivel de las facultades y departamentos.

Palabras clave: Rankings, evaluación, universidad mundial, política universitaria.

Rànquing mundials d’universitats: objectius i qualitat (Resum).

En tots els àmbits educatius i d’investigació s’ha posat de moda elaborar ránquings, és a dir, classificacions ordenades, avaluant i comparant la qualitat de les institucions o bé dels sistemes. També en l’àmbit universitari els ránquings han proliferat en l’última dècada, tant a escala mundial, com a escala nacional degut : a) a la globalització de la competició entre universitats dins del context de la societat del coneixement globalitzat; b) a la creixent demanda d’informació comparable per part dels ‘clients’ (per exemple, els estudiants i les seves familias); c) la creixent demanda per part dels governs i de la societat d’una major responsabilitat de les universitat enfront de la societat, la qual cosa es tradueix en majors exigencies de qualitat dels serveis prestats a la societat.

Aquest article presenta els resultats d’una cerca de ránquings a l’Internet i del seu rerefons metodològic. L’objectiu és: a) presentar diferents ránquings, b) analitzar els seus objectius i metodologia, i c) efectuar una crítica constructiva. Aquest és el primer de dos articles, dedicat solament a ránquings internacionals, mentre que el segon es centrarà en les classificacions de les universitats espanyoles. El nucli de l’article és la presentació de deu ránquings internacionals en forma de fitxes per a facilitar al lector una informació resumida i dividida en 4 capítols: objectiu, metodologia, presentació i comentaris. En l’apartat final, comparem els diferents ránquings i discutim la seva validesa, fent referencia també a articles sobre el tema, disponibles en línia i de lliure accés.

L’article ressalta la importància dels ránquings com a instruments de la política educativa i científica global, però aportant una visió crítica als ránquings, reconeixent, al mateix temps, que poden tenir una funció important en la millora de les actuacions de les universitats, sempre i quan anunciïn bé: els objectius dels ránquings el tipus d’universitats a que es refereixen, l’àmbit concret de l’avaluació, la metodologia emprada i que permetin realmente introduïr millores en les universitats , a nivell de les facultats i dels departaments.

Paraules claus: Ránquings, avaluació, universitat mundial, política universitària.

World rankings of universities: aims and quality (Abstract).

In all areas of education and research has coming up the trend to elaborate rankings evaluating and comparing the quality of institutions and systems. Also in the area of universities has growing, in the last decade, the number of world and national ranking due to: a) the globalization of the competition between universities within the context of a globalised knowledge economy; b) the increasing demand for comparable information from the ‘clients” (for instance: students and their families); c) the increasing demand from part of the governments and the society of a mayor responsibility of the university in front of the society, which conduced to mayor quality demand of the universities’ services to society.

This article presents the results of the Internet search for rankings and their methodological backgrounds. The objectives are a) to present different rankings; b) to analyse their objectives and methodology and c) to provide a constructive but critical view on them. This is the first of two articles about university rankings. This one focused only on international rankings, whereas the second will be about the rankings of Spanish universities. In the core of this article stands the presentation of 10 international rankings in the format of fiches in order to facilitate summarized information to the lector. The fiches are divided in 4 parts: objective, methodology, presentation and comments. In the final chapter, we will compare the different rankings and discuss their validity taking into account articles on this issue freely available in Internet.

The article underpins the relevance of rankings as instruments of global education and science policies bring in a critical vision admitting, however, that rankings could fulfil a important function in the improvement of the universities’ performance when they announced well: the objective of the ranking, the type of universities to which they refer, the concrete area of the evaluation, the used methodologies and when they permit really to face improvements in the universities at the level of faculties and departments.

Key words: Rankings, evaluation, world university, university policy.

Globale hochschulrankings: zielsetzung und qualität (Zusammenfassung).

In allen Bildungs und Wissenschaftsbereichen ist eine Trend zur Erstellung von Rankings zu beobachten, mit denen die Qualität von Institutionen und Systemen vergleichend bewertet werden sollen. Auch im Universitätsbereich hat sich in den letzten Jahren die Anzahl der weltweiten und nationalen Rankings erhöht. Dies ist geschuldet: a) dem weltweiten Wettbewerb unter den Universitäten im Rahmen der globalisierten Wissenswirtschaft; b) der wachsenden Nachfragen nach vergleichbaren Informationen seitens der ‘Kunden’ (zum Beispiel Studenten und ihren Familien); c) der stärker werdenden Forderung seitens der Regierungen und Gesellschaft nach einer höheren Verantwortlichkeit der Universitäten gegenüber der Gesellschaft, die zu höheren Ansprüchen an die Qualität der universitären Dienstleistungen führt.

In diesem Artikel werden die Ergebnisse einer Internetsuche über Rankings und den ihnen zu Grund liegenden Methodologien vorgestellt. Ziel ist es, a) verschiedenen Rankings zu beschreiben; b) die Objektive und Methodologien zu analysieren; und c) einen kritisch- konstruktiven Blick auf sie zu werfen. Es ist der erste von zwei Artikeln. Während dieser sich ausschließlich mit internationalen Rankings beschäftigt, hat der Zweite spanischen Klassifikationen zum Gegenstand. Im Zentrum dieses Artikels steht die Beschreibung von zehn internationalen Rankings in Form von Fiches. Absicht ist es den Lesern, Informationen in zusammengefasster Form, in vier Abschnitte unterteilt, vorzulegen: Ziele, Methoden, Darstellung und Kommentare. Im abschließenden Kapitel werden dann die Rankings verglichen und auf ihre Stichhaltigkeit hin untersucht. Dabei werden auch Artikel zu diesem Themen herangezogen, die frei im Internet zugänglich sind.

Der Artikel stellt die Bedeutung der Rankings als Instrument der globalen Bildungs- und Wissenschaftspolitik heraus, unterwirft sie aber einer kritischen Betrachtung. Gleichwohl wird anerkannt, dass sie eine wichtige Funktion bei der Verbesserung der universitären Performance haben können, wenn sie deutlich machen: welches ihre Zielsetzungen sind, welchen Universitätstypus sie bewerten, welchen konkreten Funktionsbereich sie bewerten, welche Methoden sie anwenden, und sie wirklich einen Beitrag zur Verbesserung der universitären Leistungsbilanz auf der Ebene der Fakultäten und Abteilungen erstellen.

Schlagwort: Rankings, evaluation, weltuniversität, hochschulpolitik.

Introducción

En todos los ámbitos educativos e investigativos, se ha puesto de moda elaborar rankings (o clasificaciones ordenadas) evaluando y comparando la calidad de las instituciones o de los sistemas. Un ejemplo muy conocido son los diferentes estudios PISA para la educación secundaria. A pesar de que su enfoque central no ha sido la elaboración de una clasificación, su efecto mediático ha sido la discusión del lugar que ocupa un país o una región. Otros ejemplos en el ámbito universitario son el Academic Ranking of World Universities (conocido como Shanghai Index o AWRU) o el World University Ranking del Times Higher Education Supplement (THES-Ranking). Y la Unión Europea ha puesto en marcha recientemente un proyecto ambicioso para elaborar una propuesta europea de ranking y estudiar su fiabilidad. También se ha creado un observatorio internacional de ranking académico y de excelencia (International Observatory on Academic Rankings and Excellence -IREG-: www.ireg-observatory.org)[1].

Éstas y otras clasificaciones ordenadas comparan universidades o facultades a través de indicadores numéricos basado en citas, impacto y ganadores de premios, usando indicadores ponderados para construir un indicador sintético que luego permite ordenar las instituciones según el mejor rendimiento detectado. La creciente importancia de las clasificaciones y su proliferación se debe, según Ellen Hazelkorn (2008), a) a la globalización de la competición entre universidades dentro del contexto de la sociedad del conocimiento globalizado; b) a la creciente demanda de información comparable por parte de los ‘clientes’ (por ejemplo, los estudiantes y sus familias); c) la creciente demanda por parte de los gobiernos y de la sociedad a una mayor responsabilidad de la universidades frente a la sociedad, lo cual se traduce en mayores exigencias de calidad de los servicios prestados a la sociedad. A esto se puede añadir que la simplicidad de los rankings favorece su impacto mediático.

Supuestamente, el uso de un número limitado de indicadores permite a las universidades obtener información sobre su posición en relación con otras universidades, lo que les convierte en un tipo de herramienta de navegación tanto para las universidades como para los políticos y agentes responsables de los sistemas de educación superior nacionales y regionales[2]; para los actores sociales con influencia en el proceso de decisión y para sus ‘clientes’[3]. Lindblat (2008) llama la atención sobre el hecho de que los mecanismos de distribución de los recursos entre las universidades dentro del sistema sueco de educación superior se basan en indicadores de rendimiento similar a los utilizados por los rankings. En este sentido, los rankings y los mecanismos de valoración de los sistemas de educación superior no solamente describen la posición de las universidades particulares en estos sistemas, sino que tienen un impacto sobre las mismas actuaciones de las universidades[4]. Hazelkorn llega a una conclusión similar, constatando que los rankings provocan un amplio abanico de cambios en la educación superior y sus sistemas[5].

En este contexto de creciente interés por las clasificaciones ordenadas de las universidades, este artículo presenta los resultados de una búsqueda de ellos en Internet y de su trasfondo metodológico. El objetivo es: a) presentar diferentes rankings, b) analizar sus objetivos y metodología, y c) efectuar una crítica constructiva.

Se trata del resultado de un programa de varios estudios sobre las universidades y la enseñanza superior, en el que se están elaborando varios artículos basados en los resultados de proyectos internacionales[6]. Uno ya está publicado por el instituto de investigación navreme[7], y éste es el primero de dos artículos sobre rankings de universidades. Este artículo está dedicado solamente a rankings internacionales, mientras que el segundo, se centrará en las clasificaciones de las universidades españolas.

El artículo empieza con una breve descripción del contexto político, resaltando la importancia de los rankings como instrumentos de la política educativa y científica global. Los ‘Berlin Principles on Ranking of Higher Education Institutions’ (2006) exponen claramente que ellos aportan un enfoque de mercado al proceso de evaluación de las instituciones educativas, pero, como veremos a continuación, no se trata solamente del enfoque de mercado –aplicar principios de competitividad no es necesariamente malo– sino que muchos de ellos promueven un cierto tipo de universidades que se ha impuesto en el discurso político como modelo a seguir.

Se enmarca también la tendencia creciente hacia las clasificaciones en la política educativa y científica basada en el control del contexto de las instituciones a través de evaluaciones externas regulares y benchmarks. Estas políticas dejan aparentemente más margen de decisión a las instituciones para cumplir su misión social, pero a través de los benchmarks y procedimientos de evaluación se limita de nuevo este margen de decisión. En otras palabras, se trata de un juego de tendencias contradictorias: mayor margen de autoorganización pero dentro de un margen de maniobra más acotado políticamente.

En el segundo apartado se presentan 10 rankings internacionales en forma de fichas. El objetivo es facilitar al lector una información resumida y dividida en 4 capítulos: objetivo, metodología, presentación y comentarios. De esta forma, el lector tendrá una impresión de las características, ventajas y problemas de las diferentes clasificaciones.

A partir de estos ficheros, en el apartado final, comparamos los diferentes rankings y discutimos su validez haciendo referencia también a artículos disponibles en línea y de acceso libre referente al tema.

Rankings como instrumentos de política educativa y científica

La creciente relevancia de los rankings se debe, en parte, a su efecto mediático, pero también está enmarcada en la política de establecer indicadores y benchmarks para comparar la evolución de estrategias políticas, sistemas e instituciones. Un benchmark es un punto de referencia para hacer comparaciones y se interpreta, generalmente, como un buen estándar para medir el rendimiento de productos, procesos, programas, organizaciones, instituciones o sistemas[8]. Benchmarking es, según la American Society for Quality, un proceso a través del cual una organización puede comparar su rendimiento con la mejor organización de su clase, determinar como esta organización ha conseguido su nivel de rendimiento y utilizar esta información para mejorar el propio[9]. Por lo tanto, establecer puntos de referencia o hacer benchmarking implica: a) que se ve la relación entre diferentes organizaciones, instituciones o sistemas como una competición para saber quién es el mejor; b) que se pueden establecer parámetros para saber quién es el mejor; c) que, a través de la comparación con el mejor, se puede aprender y mejorar el propio rendimiento; y d) que existe, en principio, una mejor forma de actuar para conseguir los objetivos establecidos.

Aplicar el benchmarking en la administración y gestión pública implica la creación de una cuasi-competición que se orienta al modelo del mercado económico[10] y que se basa en la comparación tanto de factores de entradas y salidas como de salidas de diferentes instituciones o de la misma institución en diferentes períodos temporales. En este sentido, es un procedimiento muy específico de evaluación comparativa. Y los rankings[11] son, en cierta forma, un tipo específico del benchmarking clasificando los objetos evaluados con base en indicadores (numéricos) determinados. Por otro lado, una clasificación ordenada podría ser también un paso previo en el proceso de benchmarking, determinando cuales son los mejores productos, programas, organizaciones, instituciones o sistemas. Por lo tanto, el objetivo político del benchmarking y del ranking en el ámbito de la administración pública, incluyendo la educación, es introducir una cuasi-competencia entre las instituciones públicas induciendo de esta forma un proceso (continuo) de mejoras.

La elaboración de estas clasificaciones se enmarca en la creciente tendencia a realizar evaluaciones, sobre todo, en el ámbito de la educación. Por un lado, cualquier sistema educativo se basa en las evaluaciones de los alumnos para seleccionar las personas, tanto internamente como para otros sistemas educativos (por ejemplo el paso del bachillerato a la universidad) u otros sistemas (p.ej. del mercado laboral). Por otra parte, hay una marcada tendencia en todos los países europeos a crear sistemas de evaluación externa de los sistemas educativos y de sus instituciones así como de los sistemas de investigación y de sus instituciones.

En principio, parece que hay acuerdo en que las evaluaciones del sistema educativo y de investigación podrían aportar algo positivo a los sistemas y organizaciones evaluadas, para que se mejore la calidad de la educación o de la investigación. Sin embargo, más allá de estas declaraciones generales respecto al valor de las evaluaciones, queda poco claro, en muchos casos, cuáles son los objetivos concretos de las evaluaciones y, por ende, de los rankings y cuales son los principios en que se basan estas evaluaciones.

R. Münch (2009) vincula la evaluación de PISA[12] y el proceso de Bolonia con la emergencia de una élite transnacional de expertos educativos que impone una visión educativa muy específica. Los dos procesos – tanto PISA como Bolonia - están enmarcados en la difusión de una visión guía de educación, impulsada por un grupo de expertos e instituciones que forman redes transnacionales. Dentro del discurso general sobre la creciente importancia de la educación y la formación, estas redes abogan por el concepto de capital humano como paradigma para las estrategias nacionales en dichos ámbitos. De esta forma, el modelo de la expansión de la educación general se ha convertido globalmente en el modelo estándar. Nadie duda que la expansión de la educación general debe ser un objetivo general de todas las políticas educativas[13]; pero lo que no queda tan claro es si la expansión general de la educación universitaria debe ser también un objetivo general, sobre todo si ella va en detrimento de una formación profesional diferenciada. Según Münch (2009), hasta ahora, no se ha aportado ninguna prueba de que este modelo sea mejor, comparado con otros modelos más diferenciados como el alemán, en términos de crecimiento económico, amplia inclusión social o una mayor participación de los ciudadanos en los proceso democráticos[14]. En este sentido, el análisis de los efectos deseados y no-deseados de la expansión de la educación superior debe basarse en un enfoque más integral estudiando paralelamente el desarrollo de la formación profesional.

Bajo este paradigma se están divulgando conceptos educativos muy determinantes, que están más cerca de los modelos anglosajones basados en competencias básicas generales. Analizando los resultados de PISA 2000, Münch (2009) argumenta que la orientación a estas competencias generales es ajena al currículo escolar alemán en los ámbitos de las matemáticas, de la lectura y de las ciencias naturales. Por ejemplo, en matemáticas los alumnos alemanes obtienen buenos resultados en las preguntas que se refieren a áreas especificas de las matemáticas como la geometría euclidiana, pero no tan buenos en cuanto a las preguntas básicas de las matemáticas. Las pruebas PISA, no obstante, están influidas por la “realistic mathematics education”, dominante especialmente en los EE.UU. y el Reino Unido, que ponen en el centro de sus pruebas las competencias cognitivas generales argumentado, que se trata de ejercicios más exigentes comparados con los ejercicios ‘más técnicos’ de algunas áreas específicas de las matemáticas.

En principio, se trata de un proceso de profecías que se auto-cumplen: el diseño de las pruebas induce a que los sistemas educativos diferentes al paradigma-guía del diseño obtengan peores resultados. Münch (2009) muestra que este mecanismo funciona también en el ámbito de lectura y de las ciencias naturales. Lo problemático de este enfoque es que, dado que el estudio PISA se realiza en nombre de la OECD y de sus países miembros, los resultados negativos ejercen una presión sobre los sistemas educativos nacionales para adaptarse a los estándares que están detrás del estudio. Solamente en este caso, los resultados mejoran[15].

Sin embargo, aquí no nos interesan las críticas internas a la evaluación de los sistemas educativos del proyecto PISA. Lo importante de este caso es que la evaluación está ligada a un cierto programa de política educativa y tiene la función de promover dicho programa. Ese hecho en sí mismo no es reprochable, todas las evaluaciones deben tener una base de que partir, pero hay que anunciarlo para que otros pueden apreciar el verdadero alcance de los resultados evaluativos[16].

Las evaluaciones se pueden diferenciar, en términos generales, en tres grandes bloques según el tipo del sujeto que se evalúa:

1) La evaluación de proyectos o programas es un procedimiento orientado a valorar el éxito o los resultados de un proyecto o un programa. En términos generales, los proyectos son actuaciones que se desarrollan durante un tiempo limitado, mientras que los programas son a mediano y largo plazo. El proceso de evaluación desempeña un papel importante en la toma de decisiones respecto a la prolongación del proyecto o programa y aborda -por lo menos en el caso del programa -la pertinencia de aplicar estrategias o instrumentos similares a otros ámbitos de actuación.

2) La evaluación de organizaciones se orienta, sobre todo, a la mejora de los procedimientos aplicados en las organizaciones y, por lo tanto, a la calidad de la organización. La cuestión no es la prolongación de la existencia de la organización, sino su reestructuración a mediano y largo plazo con el objetivo de mejorar su calidad.

3) La evaluación de productos está enfocada a la mejora de una producto material o inmaterial. Generalmente se trata de una evaluación para ver la utilidad del mismo para un consumidor. El objetivo es mejorar la aceptación del producto entre un público determinado.

Parece difícil clasificar la evaluación de las universidades en este esquema. Las universidades podrían entenderse como un programa educativo de muy larga duración respondiendo a necesidades educativas y formativas, pero también científicas y tecnológicas, de la sociedad. Sin embargo, las necesidades educativas y formativas de la sociedad cambian a lo largo del tiempo, lo que debe reflejarse en el programa “universidad”. Además, tanto la sociedad como las universidades son entidades sociales muy complejas que no pueden reducirse a una necesidad y un aspecto del programa.

La evaluación de las universidades como organizaciones presenta una problemática parecida a la de la evaluación del programa. La mejora de los procedimientos de la organización depende de cual sea la meta de la misma, la que, en el caso de las universidades, depende a su vez de las necesidades educativas, científicas y tecnológicas de la sociedad. Satisfacer estas necesidades complejas y muchas veces contradictorias es una tarea igualmente compleja y complicada, además, en consecuencia, también lo es la evaluación de la universidad como organización.

La evaluación de las universidades considerándolas como producto o servicio parece más simple que los dos tipos de evaluación anterior. Sin embargo, este tipo de evaluación implica definir la relación entre universidad y sociedad en términos de mercado como proveedora de servicios, es decir universidad y cliente de servicios, a saber, la sociedad, la economía o los ciudadanos. Pero, como en los dos tipos de evaluaciones anteriores, el asunto se complica por el hecho de que la universidad no está orientada solo a un tipo de servicios sino a una variedad de ellos. Y tampoco queda claro quién es realmente el cliente de estos servicios, dado que la sociedad en general está compuesta por una variedad de sistemas sociales como la economía, la cultura, la religión etc.

La solución que adoptan las diferentes evaluaciones que se revisan a continuación consiste en reducir el campo de evaluación. Tomando de nuevo el ejemplo de PISA, se trata de una evaluación de servicios enfocada a la creación de capital humano para la sociedad en términos de competencias matemáticas, competencias lectoras y competencias de ciencias naturales. Se aplica esta evaluación a todos los sistemas educativos, independientemente de si están orientados realmente a este tipo de servicio. Como veremos más adelante, también las dos evaluaciones internacionales de universidades más conocidas el AWRU y el THES-QS son más bien evaluaciones de producto/servicio. En el primer caso del producto científico y, en el segundo, de un conjunto de productos científicos y educativos.

No queremos entrar aquí en una discusión detallada sobre los distintos conceptos y enfoques evaluativos, sino centrarnos ahora en la evaluación de producto, que es la que rige la mayoría de las evaluaciones de universidades disponibles en Internet. Hablando de productos, los rankings toman discursivamente la decisión por un enfoque de mercado[17]. La evaluación de producto, según B. Worthen, J. Sanders y J. Fitzpatrick (1997) se denomina también evaluación orientada al consumidor y tiene como objetivo general aportar información útil para la toma de decisiones sobre la adquisición o el uso de un determinado producto. Este tipo de evaluación no se restringe sólo a los productos materiales, sino que incluye también la evaluación de servicios y de instituciones que ofrecen servicios específicos, como por ejemplo las escuelas y universidades o los servicios públicos de empleo. En este sentido, la educación superior es concebida como un mercado en que los clientes comprueban productos y se deciden por un uno a base de información imperfecta. Las evaluaciones aportan información adicional para que el cliente puede tomar una decisión.

Se trata, en términos generales, de una evaluación descriptiva, es decir, en forma de un resumen concluyente en un determinado punto temporal, que se rige por el paradigma del control. Sin embargo, en el caso de los servicios o el desarrollo de productos la evaluación puede enfocarse también desde el paradigma del desarrollo, adoptando un enfoque formativo, de asesoramiento y de apoyo. Con este enfoque los criterios y resultados de la evaluación se convierten en el punto de referencia para el desarrollo futuro de la oferta de bienes y servicios.

Lo que diferencia el ranking de otro tipo de evaluación es que se comparan diferentes productos/ servicios y programas entre si y se establece un orden de calidad entre ellos[18]. La máxima y muy común expresión de esta metodología es adjudicar valores numéricos a los diferentes indicadores de calidad y calcular posteriormente un indicador sintético que permite establecer un orden descendente desde el primero hasta el último. Intrínsecamente se parte de la suposición de que los diferentes productos, servicios u organizaciones están en competición entre si para saber quién es el mejor. La metodología del ranking aporta un enfoque de mercado al proceso de evaluación de las instituciones educativas. Partiendo de este punto, el IREG (International Observatory on Academic Rankings and Excellence) establece los siguientes principios para las clasificaciones jerarquizadas de instituciones de la educación superior[19]:

1. Propósito y objetivos del ranking

- Ser uno de los varios métodos de asesoramiento de las inversiones, de los resultados y de los procesos de la educación superior.

- Ser transparente, definiendo claramente los objetivos y los grupos a que se dirige el ranking.

- Reconocer la diversidad de las instituciones y tener en cuenta sus diferentes misiones y objetivos.

- Facilitar transparencia respecto a la relevancia de las fuentes de información y de la información que genera cada fuente.

- Especificar el contexto lingüístico, cultural, económico e histórico de los sistemas educativos sometidos al proceso de ranking.

2. Diseño y ponderación de los indicadores

- Ser transparente respecto a las metodologías usadas para crear el ranking.

- Seleccionar indicadores de acuerdo con su relevancia y validez.

- Orientar la evaluación preferentemente a los resultados (output) en lugar de a las inversiones (input) siempre que sea posible.

- Resaltar el peso asignado a cada indicador (en el caso de la ponderación) y cambiarlo lo menos posible.

3. Recopilación y procesamiento de datos

- Prestar una atención adecuada a los estándares éticos y las recomendaciones de buenas prácticas expresadas en los principios formulados por el IREG.

- Usar siempre datos auditados y verificados si es posible.

- Incluir datos que son recogidos según los procedimientos adecuados de la recogida científica de datos.

- Aplicar medidas para garantizar la calidad en el mismo proceso del ranking

- Aplicar medidas organizativas, p.ej. creación de consejos de asesores para asegurar la credibilidad del ranking.

4. Presentación de los resultados

- Facilitar al cliente una explicación clara de todos los factores usados para la elaboración del ranking y ofrecerles la elección de como el ranking se visualizará.

- Recopilar la información de tal manera que se eliminen o reduzcan los errores en los datos originales y asegurar que el ranking será organizado y publicado de tal forma que los errores y las faltas podrían ser corregidos.

Por lo tanto, para evaluar a continuación los diferentes rankings de las universidades se debe preguntar siempre por sus objetivos y por el valor añadido que facilitan (o no) para una toma de decisión orientada a mejorar la actuación de la universidad o del sistema, o para tomar una decisión sobre dónde estudiar o a qué institución se contrata para un proyecto de investigación.

Diez rankings internacionales

La presentación de los diferentes rankings parte del supuesto de que no se elaboran por mero capricho, sino por objetivos muy concretos, que se insertan en su diseño. Por este motivo, presentamos, a continuación, las fichas de los rankings más relevantes en el ámbito de la educación superior, incluyendo los siguientes apartados:

a) Objetivo, que corresponde al punto (1) de los principios de Berlín

b) Metodología, que corresponde a los puntos (2) y (3)

c) Presentación, que corresponde al punto (4)

d) Comentario

Para la elaboración de los ficheros, hemos recurrido a la información ofrecida por las mismas instituciones, que han elaborado las clasificaciones ordenadas, en sus páginas Web o en publicaciones en línea. En general, exponemos directamente esta información con ciertos recortes, pero sin señalar expresamente que se trata de citas. En el caso de los rankings internacionales, los autores de este artículo han traducido gran parte de la información expuesta en las páginas Web respectivas. Por eso, en relación a los ficheros no se reclama la autoría de lo expuesto.

Aquí se presentan solo los rankings que son accesibles vía Internet y cuando en los documentos electrónicos de referencia consta claramente la autoría y se explica la metodología usada. La experiencia con dos clasificaciones elaboradas por entidades españolas[20] nos aconseja esta prudencia, dado que circulan en Internet versiones no autorizadas o artículos basados en datos no autorizados.

FICHA 1: Academic Ranking of World Universities

<http://ed.sjtu.edu.cn/ranking.htm>

Objetivo

El Academic Ranking of World Universities[21] (ARWU) ha sido elaborado por el Instituto de Educación Superior de la Universidad Shanghai Jiao Tong con el objetivo de medir la posición de las universidades chinas de investigación en el mundo[22]. Se publicó por primera vez en 2003. Con los años, se ha convertido en una de las clasificaciones de referencia para medir la posición de las universidades analizadas respecto a la comunidad universitaria global, pero también para medir la posición de los sistemas de investigación nacional.

Metodología

El ARWU no evalúa todas las universidades, sino solamente aquellas que han pasado un filtro de selección. La lista de universidades evaluadas incluye cualquier institución que tenga un ganador de un premio Nobel, un ganador de una medalla Fields o un investigador muy citado. Adicionalmente se incluyen también las mayores universidades de cada país que tienen un número significante de artículos indexado en Science Citation Index-Expanded (SCIE) y Social Science Citation Index (SSCI), que forman parte de la Web of Science, propiedad de la empresa Thomson Reuter. En total más de 2.000 instituciones están actualmente analizadas. De estas, 1.200 universidades entran en la clasificación, pero solamente se publica el ranking de las primeras 500 universidades

Las instituciones están listadas en cinco amplios campos de conocimiento incluyendo ciencias naturales y matemáticas (SCI); ingeniería/ tecnología y ciencias de computación (ENG), ciencias de la vida y de agricultura (LIFE), medicina clínica y farmacia (MED) y ciencias sociales (SOC). Artes y humanidades no están clasificadas debido a los problemas técnicos de establecer indicadores internacionalmente comparables con datos fiables. Psicología/psiquiatría no están listados debido a su carácter multidisciplinario.

Las instituciones están ordenadas por el rendimiento académico e investigador en cada uno de los campos de conocimiento. Los indicadores incluyen alumnos y personal usando los mismos criterios utilizados para la selección de universidades. Dos nuevos indicadores ha sido introducidos; uno es el porcentaje de artículos publicados en las revistas situadas entre los mejores 20% de cada campo, y el otro los gastos en investigación de ingeniería.

Para elaborar la clasificación, se usa la metodología de puntuación para cada uno de los indicadores y para la totalidad de los indicadores. Para cada indicador, a la institución con el máximo valor obtenido se le asignan 100 puntos, y los puntos de las otras instituciones se calculan como porcentaje de este valor máximo. La distribución de los datos de cada indicador será analizada si aparece un efecto de distorsión y las técnicas estadísticas estándar se utilizan para ajustar el indicador en caso de que sea necesario. Los puntos de cada indicador se ponderan para llegar a la puntuación general final de cada institución. A la institución mejor valorada se le asignan un total de 100 puntos y para las demás instituciones su puntuación se calcula como porcentaje de este valor total máximo. Los puntos se clasifican luego según orden descendente.

En el ranking del año 2008 se establecen indicadores en cuatro dimensiones (módulos):

1. Módulo Calidad de la Educación: Alumni indica el número total de los alumnos de una institución que han ganado un premio Nobel en física, química, medicina y economía o una medalla Fields en matemática. Se define como alumnos aquellos que han obtenidos un Bachelor, Master o doctorado en la institución. Diferentes ponderaciones son asignadas de acuerdo con el período en que obtuvieron el grado: La ponderación es 100% para los alumnos que han obtenido el grado entre 1991 y 2000; 80% para los alumnos que hayan obtenido su grado entre 1981 y 1990; 60% para los alumnos que hayan obtenido su grado entre 1971 y 1980; 40% para los alumnos que hayan obtenido su grado entre 1961 y 1979 y finalmente 20% para los alumnos que han obtenido su grado entre 1951 y 1960. Si una persona ha obtenido mas de un grado en una institución, está institución es considerada solamente una vez. Los premios Nobel en psicología y medicina son incluidos tanto en el ranking de LIFE como MED. Peso: 10%.

2. Módulo Calidad de la facultad: a) Premio (Award) indica el número total del personal de una institución que ha ganado premios Nobel en física, química, medicina y economía o medallas Fields en matemática. Personal es definido como las personas que trabajaban en la institución cuando ganaron el premio. Diferentes ponderaciones son asignadas de acuerdo con el período de obtención del premio. La ponderación es 100% por haberlo ganado entre 2001 y 2007; 80% por haberlo ganado entre 1991 y 2000, 60% por haberlo ganado entre 1981 y 1990, 40% por haberlo ganado entre 1971 y 1980 y finalmente 20% por haberlo ganado entre 1961 a 1970. Si un ganador está afiliado a más de una institución, a cada una de ellas se asigna un valor relativo al número de las instituciones. Si un premio Nobel ha sido asignado a más de un persona, las ponderaciones serán asignadas a los ganadores según su proporción del premio. Los premios Nobel en psicología y medicina son incluidos tanto en el ranking de LIFE como MED. Peso 20%.

b) HiCi indica el número de los investigadores muy citados en 21 categorías temáticas establecidas, utilizando información facilitado por isihighlycited.com. Estos investigadores muy citados son asignados a 5 campos de conocimiento. Si un investigador está incluido en más de una categoría de conocimiento, su peso en cada una de estas categorías será relativo al número de las categorías en que aparezca. Especialmente se revisa a los investigadores incluidos en el Social Science General Category uno por uno, para que sean reclasificados en tres grupos según su afiliación en colegios o departamentos. Las personas que trabajan para unidades vinculadas a sanidad, como escuelas de médicos o de enfermeras, son agrupados en el ranking MED. Las personas afiliadas a departamentos de psicología o psiquiatría no son incluidas en el ranking. Otros individuos en esta categoría son incluidos en el SOC-ranking. Peso: 20%.

3. Módulo Resultado de Investigación: a) N&S - ciencias naturales & ciencias indica el número de artículos publicados en ciencias naturales y ciencias entre 2003 y 2007. Para distinguir diferentes formas de autorías se pondera según el número de autores y su clasificación como autor principal, segundo autor etc. Solamente se toma en consideración publicaciones de tipo artículos. La fuente de referencia es ISI-knowledge. Peso: 20%.

b) PUB indica el número total de artículos indexados en el Science Citation Index-Expanded y Social Science Citation Index del 2007. Solamente se toman en consideración publicaciones de tipo artículos. Cada articulo publicado por una institución es clasificado en uno de los seis campos de conocimiento de acuerdo con la revista en que está publicado (Classification of Journal Categories), incluyendo los cinco campos de conocimiento mencionados anteriormente y ciencias inter- y multidisciplinarias. Si un artículo es publicado en una revista de varios campos (es decir que es clasificado en mas de una categoría de ISI), se divide entre estos grupos. Peso: 20%.

4. Módulo Rendimiento per Capita: PCP El indicador sintético ponderado de los indicadores anteriormente mencionados dividido por el número equivalente al personal académico a tiempo completo de la universidad en cuestión (por ejemplo: Australia, Bélgica, China, Corea de Sur, EE.UU., Italia, Japón, Nueva Zelanda, los Países Bajos, Reino Unido, Rep. Checa, Suecia, Suiza). En el caso de que no se obtenga el dato del personal académico se utiliza la puntuación ponderada de los 5 indicadores mencionados anteriormente. Peso: 10%.

Presentación

En formato de tabla de instituciones ordenadas por las mejores puntuaciones obtenidas. Los resultados se presentan también por regiones (Norte y Latino-America; Europa; y Asía del Pacifico.

La tabla de las 100 mejores universidades mundiales del AWRU

(2009)

Nota: por razones de espacio se presenta aquí el recorte de las primeras veinte

universidades

En la Web del ARWU, se presentan también datos por áreas de conocimiento: ciencias naturales y matemáticas, ingeniería y tecnología, ciencias de la vida y agricultura, medicina clínica y farmacia, y ciencias sociales. Aquí, mostramos solamente una parte de las clasificaciones en el área de las ciencias sociales.

La tabla de las 100 mejores universidades mundiales en

ciencias sociales del AWRU (2009)

Nota: por razones de espacio se presenta aquí el recorte de las primeras veinte

universidades

Se presentan también estadísticas respecto a la presencia de las regiones en la clasificación ARWU, y también la posición de las universidades según el área de conocimiento.

Estadística del ARWU (2009) de la distribución regional de

las mejores universidades mundiales

Nota: por razones de espacio se presenta aquí el recorte de los primeros 5

países

La tabla del ARWU (2009) de la posición de las mejores

universidades mundiales

según área de conocimiento

Nota: por razones de espacio se presenta aquí el recorte de los primeros 10

países

Comentario

Los propios autores del ranking mencionan algunos problemas del mismo:

a) La calidad de las universidades no se puede medir utilizando simplemente números.

b) Ningún ranking es objetivo

c) Medir universidades en todo el mundo es, en principio, imposible dada la gran diferencia entre las universidades y los sistemas de educación superior o de investigación.

d) Existen problemas metodológicos respecto a los indicadores sobre enseñanza y servicios, la ponderación del rendimiento por cabeza, la tipología de las universidades, el sesgo idiomático de las publicaciones, la selección de los premios y la experiencia de los ganadores de los premios.

e) Existen problemas técnicos respecto a la definición de las instituciones, de la atribución de publicaciones y premios, y la historia de las instituciones.

Por otro lado, una revisión de los indicadores muestra lo siguiente:

- El ARWU-Index está centrado en las ciencias naturales y matemáticas (y economía). Los indicadores de premios están casi exclusivamente centrados en este tipo de ciencias. No se ha buscado indicadores similares para otras ciencias. Los indicadores de premios dicen algo sobre el prestigio internacional de una institución, pero no necesariamente sobre la calidad (actual) de la investigación comparada con otras instituciones. En el caso de premios Nobel se trata muchas veces del reconocimiento posterior de logros científicos conseguido en el pasado. P.ej. los premios Nobel de física del año 2009 han sido concedidos a tres científicos de los EE.UU William Sterling Boyle, Charles Kuen Kao y George Elwood Smith, por sus descubrimientos hechos en los años 1960, y están ya jubilados. Y no necesariamente se premia una innovación relevante: por ejemplo Einstein nunca consiguió un premio Nobel por su teoría de relatividad. El ejemplo de Einstein muestra también lo dudoso de los premios para evaluar la calidad de la educación. Einstein desarrolló su teoría de la relatividad fuera de los circuitos institucionales de las ciencias naturales. Además, la concesión de un premio es en gran parte un proceso político en elque el mérito científico no es necesariamente el factor más importante (véase Marginson & van der Wende 2007)

- También el indicador HiCi parece ciertamente sesgado. Por ejemplo, revisando la base de datos de ISIHighlyCited con respecto a las ciencias sociales se observa que en la lista aparecen casi exclusivamente autores de habla inglesa. En un artículo reciente Docampo [2008] argumenta que el sesgo anglosajón no es tan pronunciado como los críticos indican y pone como ejemplo la posición destacable de los países escandinavos y de los Países Bajos y el avance de España en este índex. Sin embargo, este hecho se puede interpretar: a) como una adaptación paulatina y general de los sistemas de la ciencias al idioma dominante o a la lengua franca, el inglés, y b) que esta adaptación se produce más lentamente en países de idiomas de mayor uso y de sistemas de ciencias históricamente consolidados como Francia y Alemania. En este sentido, se puede predecir, que el ARWU-Index será más equilibrado respecto a los sistemas de ciencias nacionales cuando todos los países se hayan adaptado plenamente a la lengua franca en las ciencias[23]. No obstante, se puede predecir que, de cierta forma, este sesgo se mantendrá en el ámbito de las ciencias sociales y humanas dado su arraigo en el contexto socio-lingüístico.

- También los indicadores de artículos citados demuestran cierta tendencia a que prevalezca cierto tipo de ciencias dado que en las ciencias sociales se valora mucho aún la publicación de libros como medio de diseminación principal. A primera vista, revisar las citas de todos los libros publicados en un área en el curso de un año es un trabajo casi imposible de realizar.

- El índex valora exclusivamente el prestigio científico de una institución y no tiene ningún valor para una evaluación comparativa en el ámbito de la educación.

- El índex valora solamente el prestigio intrínseco del sistema científico pero no su valor para la sociedad. De esta forma se limita a medir la calidad científica tradicional.

- Finalmente está el problema de la puntuación general de las instituciones. Queda abierta la cuestión de si realmente se pueden juntar premios y citas en un único índex. Una de las críticas importantes, no solamente al ARWU-ranking sino también a otros, es que el sistema de ponderación no esta suficientemente explicado y razonado.

Los propios autores mencionan algunos de estos puntos críticos, pero no evalúan la instrumentalización política de este ranking. Con su decisión de centrar su clasificación en el ámbito de la investigación y con la definición de sus indicadores, esta clasificación favorece las universidades que son suficientemente grandes y diversificadas en sus campos de investigación para acumular la masa suficiente para entrar en la lista. El ranking está enfocado (y favorece) a las universidades fuertemente orientadas a la investigación en ciencias naturales y matemáticas en la tradición estadounidense y británica. El resultado muestra que las universidades de habla inglesa (Australia, EE.UU., Irlanda, Nueva Zelandia y Reino Unido) representan el 95% del Top20, 57% del Top100, 56,7 del Top200 y aún el 46,2% del Top500.

Los propios autores reconocen el problema de que la clasificación tiene un sesgo a favor de las universidades de habla inglesa, pero no pueden evitar que su ranking sea utilizado en el discurso público como argumento para resaltar la supuesta ventaja del sistema anglosajón de educación superior y de investigación respecto a los demás sistemas[24]. El uso político queda en evidencia si se utiliza otro esquema de interpretación refiriéndose a las entidades políticas UE-27 y EE.UU. Los EE.UU. tienen más universidades entre las 100 mejores (51 por 32), las 200 mejores (90 por 71) y en menor medida entre las 300 mejores (119 por 117), pero entre las 400 mejores (139 por 159) y las 500 mejores (170 por 195) las universidades de la UE están mejor situadas. El hecho de que la relación haya evolucionada a favor de las universidades de la UE, se puede interpretar como una mejora de la calidad científica de las universidades de la UE, que incluye, desde luego, las universidades británicas e irlandesas, pero también se debe a una afinamiento de la metodología.

La elaboración de este tipo de clasificación es válida bajo criterios científicos asumiendo las limitaciones del campo de evaluación, tanto respecto al tipo de universidades como a la misión de la universidad y a la metodología usada. El problema reside en el hecho de que este ranking promueve un cierto modelo de universidad, que aparentemente se ha convertido en el modelo dominante en el ámbito político.

FICHA 2: World University Ranking

<http://www.timeshighereducation.co.uk/WorldUniversityRankings2009.html>.

<http://www.topuniversities.com/worlduniversityrankings>.

Objetivo

El World University Ranking del Times Higher Education Supplement (THES-Ranking) evalúa alrededor de 600 universidades en el mundo y publica una clasificación de las 400 mejores. Se han establecido seis indicadores que en su conjunto forman el ranking de las universidades mundiales. A parte se elaboran clasificaciones ordenadas en cinco áreas de conocimiento claves: Arte & Humanidades, Ingeniería & IT, Ciencias de la Vida & Biomedicina, Ciencias Naturales, Ciencias Sociales.

El concepto del THES-Ranking es el reconocimiento de las universidades como organizaciones multifacéticas para la comparación global de su éxito en la carrera para convertirse o ser una universidad de la primera clase mundial. Se exige cada vez más a las universidades competir para tener las mejores facultades, formar los mejores estudiantes, obtener los contratos de investigación más lucrativos y obtener más fondos gubernamentales. En este contexto, el término “World Class University” es cada vez más importante para los gobiernos, los empleadores, los inversores, los estudiantes y las propias universidades. Pero sin mediciones es difícil identificar la universidad que cualifica o investiga mejor.

El ranking se establece con base en cuatro criterios: calidad de investigación, calidad de enseñanza, empleo de los graduados e imagen internacional. El THES-Ranking se realiza utilizando seis indicadores: calidad académica, calidad de enseñanza, empleabilidad, prestigio académico y prestigio internacional.

Metodología

En el centro de la metodología hay dos encuestas en línea:

Perspectiva Académica

Se trata de la parte más importante del THES-Ranking teniendo un peso de 40% en su conjunto. Es una encuesta global en línea entre académicos, preguntando por la identificación de aquellas universidades que ellos consideran excelentes en su campo de conocimiento. Los encuestados no pueden incluir su propia universidad en sus respuestas. En la encuesta de 2008 se pidió a los encuestados distinguir en su respuestas entre las universidades de su propio país y de otros. La encuesta es distribuida entre los que ha participado en encuestas previas y los suscriptores de las bases de datos de “World Scientific” y de “International Book Information Services”, lo cual significa más de 600.000 direcciones electrónicas.

La clasificación de 2008 se basa en un total de 6.354 respuestas. Se tienen en cuenta las respuestas de los últimos tres años. En el caso de varias respuestas del mismo académico en el curso de estos tres años, solamente la última respuesta será tomada en cuenta. Las respuestas son ponderadas por área geográfica en cada de las áreas de conocimiento establecidas para asegurar una representación igual de las tres super-regiones establecidas: Américas; Europa & Medio Oriente & África conjuntamente y Asia del Pacifico. Las cinco áreas de conocimiento son combinadas con base en que cada uno tenga el mismo peso en el resultado conjunto.

Perspectiva de empleadores

Este tipo de encuesta se ha introducido en el año 2005 en la evaluación para cubrir la dimensión del empleo de graduados. Se considera más apropiada la encuesta que los datos estadísticos sobre empleo de graduados y sus salarios, dado que éstos están influidos por factores locales. Se trata de una encuesta entre empleadores que contratan graduados pidiéndoles que identifiquen las universidades que consideran que preparan mejor a éstos para su puesto de trabajo. El procedimiento, incluyendo la ponderación, es el mismo tanto para los empleadores como para los académicos.

Los empleadores son contactados a través de la base de datos de QS (Quacquarelli Symonds – empresa que realizó el THES-Ranking 2008); las redes de socios con que QS está cooperando, y se invita a instituciones participantes a facilitar contactos. En 2008 se contaba con 2.339 respuestas de parte de los empleadores. El resultado de esta encuesta significa un 10% en el conjunto de la evaluación.

Las encuestas se complementan con análisis de datos estadísticos en tres apartados: calidad de enseñanza, prestigio académico e internacionalización.

Calidad de enseñanza

Se considera que el único indicador reconocido internacionalmente para medir la calidad de la enseñanza es la tasa de estudiantes por universidad. No se trata de un indicador suficiente para medir la calidad, pero es el único que es medible globalmente y es un indicador del compromiso de las instituciones (o del sistema) con la enseñanza. Para el cálculo de este indicador se usan dos tipos de datos:

a) El equivalente al estudiante a tiempo completo sumando los datos de las cifras de estudiantes separados por estudiantes en fase de graduados y en fase de postgraduados. Cuando estos datos no están disponibles por separado, se usa la cifra total de estudiantes.

b) El equivalente al miembro de la universidad a tiempo completo usando el número total de los miembros de universidad sin distinguir entre personal educativo y personal investigador por motivos de disponibilidad de datos.

Para obtener estos datos, se usan los datos facilitados por la propia institución y se los contrasta con datos del gobierno, de agencias de enseñanza superior, de fuentes del Internet y de terceros.

Prestigio científico

Para medir el prestigio científico se combinan datos sobre la productividad y la calidad científica, tomando como referencia la institución. Como indicador se toma la cita, que es usada frecuentemente para medir la calidad científica. La fuente para obtener estos datos es Scopus, considerada una de las bases de datos más amplia de resúmenes y citas del mundo. El período de tiempo considerado es de los últimos cinco años. El número total de citas es contrastado por el número de los miembros de la facultad en términos del equivalente a tiempo completo. Este indicador tiene un peso del 20% en el conjunto total de la evaluación.

Internacionalización

En el mundo globalizado, las universidades de más éxito deben atraer los estudiantes y personal académico. La simple evaluación de la proporción de los estudiantes internacionales y de los miembros internacionales de facultad sirve como indicadores de la atracción internacional. Cada uno de estos indicadores significa 5% del conjunto de la evaluación.

Los indicadores son combinados usando métodos estadísticos estándares para conseguir los resultados generales del ranking y ponderando cada uno de los indicadores según su peso en el resultado general, como se ha mencionado en la descripción de los indicadores: perspectiva Académica: 40%, perspectiva empleador 10%, tasa estudiantes-facultad 20%, prestigio científico de la facultad (citas) 20% e internacionalización 5%.

Una vez recogidos los datos y aplicada la ponderación, se procede un cálculo de la puntuación estándar de cada columna de datos para que sean compatibles entre ellos y permitan combinar de forma fiable y aplicar una ponderación justa en el calculo de la puntuación general.

Presentación

Los resultados del año actual se presentan en formato de tablas en tres apartados: a) los resultados generales ordenando las mejores 200 universidades por orden descendente según el resultado global, presentando en la misma tabla los resultados por cada indicador.

La tabla de las 200 mejores universidades del THES-Ranking

(2009)

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras

universidades

b) Los resultados por área de conocimiento. El ejemplo siguiente de las ciencias sociales muestra que esta tabla solamente recoge la puntuación general en el campo y el índex de citas.

La tabla de las 50 mejores universidades en ciencias

sociales del THES-Ranking (2009)

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras

universidades

c) Los resultados por indicador.

Los informes de los años anteriores se pueden bajar en formato pdf. Éstos presentan información más detallada. En la Web de Times Higher Education, el acceso a esta información sobre el ranking más actual no se ofrece, y en el caso de la Web de Top Universities está restringido. A continuación exponemos las tablas de los dos indicadores más importantes de este ranking: las mejores universidades según los académicos y según empleadores del ranking 2007.

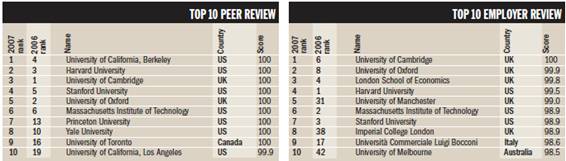

Tabla de las 10 mejores universidades

según académicos y según empleadores (2007 y 2006)

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras

universidades

Comentario

Comparado con el ARWU, el THES-Ranking parece más equilibrado respecto a la recogida de datos, basándose en encuestas en línea entre académicos y empleados y datos estadísticos sobre el número de estudiantes, miembros de facultad, citas etc. Igualmente, establece una variedad de ámbitos de evaluación tales como investigación, enseñanza, empleabilidad y prestigio. Se trata de una evaluación multidimensional del producto universidad y se presentan los resultados desagregados y agregados.

El núcleo de la clasificación es la encuesta entre académicos sobre la excelencia académica de otras universidades. Las encuestas sobre el prestigio académico tienen el riesgo de favorecer a las universidades más conocidas. La encuesta no cumple estándares de transparencia ni respecto a la publicación del cuestionario ni respecto a la procedencia geográfica de las respuestas, lo que es importante para valorar adecuadamente los resultados de la misma.

El éxito de la encuesta, en cuanto a respuestas, parece también limitado. EL THES-Ranking presume de una larga lista de direcciones electrónicas (más de 600.000 direcciones), pero las respuestas no significan ni un 1% de esta cantidad de direcciones. El THES-Ranking tampoco publica de qué áreas geográficas proceden las respuestas.

El riesgo de una encuesta entre los académicos sobre la excelencia académica de otras universidades es la suposición de que los académicos conocen realmente la calidad de investigación en su disciplina. Dado a la creciente especialización de la ciencia en sub-disciplinas se puede tener dudas sobre este supuesto.

El índex de citas tampoco parece que cubra adecuadamente todo el espectro de las ciencias globales. Como ya se ha dicho en la critica del ARWU, la base de datos de artículos, en este caso de Scopus, tiene un cierto sesgo idiomático a favor del actual idioma franco en las ciencias: el inglés.

Como en el ARWU, el índex de citas hace referencia solamente a artículos y no incluye libros, lo que refuerza un determinado estilo de publicación científica es decir, una tendencia a publicar artículos en lugar de libros. Este indicador valora exclusivamente el prestigio científico de una institución y solamente tienen un valor limitado para una evaluación comparativa en el ámbito de la educación.

También es discutible el indicador de internacionalización. Un alto porcentaje de miembros internacionales de una facultad no es necesariamente un indicador positivo sino un indicador de un sistema universitario poco desarrollado que no puede proveer el personal académico necesario para las exigencias del propio sistema económico-científico.

Medir la calidad de la enseñanza a través del indicador de la tasa entre estudiantes y personal académico no parece suficiente. Es decir, la calidad no es medible usando solamente un único indicador cuantitativo. Los propios autores del ranking reconocen esta limitación, pero defienden el indicador por ser el único internacionalmente reconocido.

Este ranking ha recibido críticas por la creación de ‘anomalías’ en los puestos que ocupan algunas universidades en las diferentes clasificaciones anuales. Marginson (2006) menciona el ejemplo de la University of Malaya, que en 2004 ha obtenido el puesto 89 en el ranking para bajar en el año siguiente al puesto 169. Pero también menciona otros ejemplos como la universidad Fudan (China) que en los ranking 2004, 2005 y 2006 ocupó los puestos 195, 72 y 116 respectivamente, o la universidad de Osaka (Japon – 69 – 105 – 70), la universidad de Munich (Alemania – 99 –55 –98) o la Ecole Polytechnique (Francia 27 – 10 – 37). En otras palabras, los resultados parecen bastante volátiles, lo que plantea algunas dudas sobre la metodología.

FICHA 3: New Global University Ranking

<www.globaluniversitiesranking.org>.

Objetivo

El New Global University Ranking (RatER-Ranking) elaborado por el instituto ruso Rating of Educational Resources (RatER) tiene el mismo objetivo que el ARWU-Ranking en su origen: medir la posición de las universidades nacionales (en este caso Rusia, en el caso de ARWU China) entre las universidades lideres mundiales y su progreso en la competición global entre universidades. En el trasfondo, está el objetivo de elaborar una clasificación alternativa al AWRU y THES-Ranking, donde las universidades de habla inglesa parecen tener ventajas competitivas. Se usa la metodología de “rating” porque permite reducir las actividades complejas de las universidades a una serie de indicadores numéricos ordinarios y comparables. Esta clasificación[25] no toma en cuenta sólo las actividades investigadoras de las universidades sino también las educadoras, considerando que la tarea principal de las universidades rusas es actualmente la provisión de una educación de calidad que cumpla con los estándares educativos establecidos por el Estado y responda a los requerimientos del mercado laboral. Como clientes potenciales del ranking se definen los siguientes: Nuevos estudiantes, las administraciones de universidad, los departamentos de recursos humanos de grandes empresas, grandes filántropos y representantes de las administraciones públicas nacionales e internacionales.

Metodología

El RatER-Ranking toma como referencia cuatro rankings globales: ARWU, el THES-Ranking, Webometrics y el Ranking de la National Taiwan University. Se tomó la decisión de que las universidades evaluadas en estas clasificaciones deben ser también sujeto de este nuevo ranking. Sin embargo, esta evaluación clasificadora no se limita a estas universidades, a quienes se dirigieron sus organizadores enviándoles el cuestionario por escrito, sino también a otras universidades, que quisieron participar en el estudio, abriéndoles la oportunidad de participar a través de un cuestionario electrónico. En otras palabras, se obtienen los datos-base de la evaluación clasificadora a través de un encuesta por escrito o en línea, fijando un tiempo limite de entrega de los cuestionarios.

Se definen siete dimensiones a evaluar. En cada una de ellas se elaboran una serie de indicadores:

1. Módulo rendimiento académico de la universidad: a) número de programas de estudios en el año académico de referencia en los tres niveles de estudios; b) número del personal académico a tiempo completo en el año académico de referencia; c) número de estudiantes matriculados en la universidad en el año académico de referencia por nivel de estudios; d) ganadores de competiciones académicas internacionales de estudiantes desde 2001.

2. Módulo rendimiento investigador de la universidad: a) número de descubrimientos certificados e inventos patentados obtenidos por la universidad o su personal académico; b) número de profesores (doctores) honoríficos, que son premios Nobel, ganadores de una medalla Field o de otro premio científico mundial desde 2001; c) número de premios mundiales recibidos por parte del personal académico de la universidad.

3. Módulo del prestigio científico de la universidad: a) número total de publicaciones (artículos, libros de texto y manuales, monográficos etc.) en el año académico de referencia; b) porcentaje del personal académico que ha recibido su titulación en el último año académico; c) número total de profesores de la universidad que han sido miembros en academias de ciencia nacionales o internacionales en el último año académico; d) promedio de citas y referencias de la publicación del personal académico por parte de autores extranjeros en el último año académico.

4. Módulo disponibilidad de recursos: a) presupuesto total de la universidad incluyendo todo tipo de ingresos del último año fiscal; b) coste total de la infraestructura educativa e investigadora del último año fiscal; c) rendimiento del centro de computación de la universidad.

5. Módulo actividad socialmente relevante de graduados de la universidad: a) número total de graduados de la universidad que han conseguido el reconocimiento público.

6. Módulo internacionalización de la universidad: a) número de comunidades académicas internacionales en que la universidad participa; b) número total de universidades extranjeras con las que se tienen acuerdos bilaterales en el último año académico; c) número total del personal académico que son profesores (doctores) honoríficos de universidades extranjeras; número total de estudiantes extranjeros que han estudiado en la universidad el último año académico; d) número total de estudiantes matriculados en la universidad que han ido a estudiar en una universidad extranjera en el último año académico (educación inclusiva) y número total del personal académico de la universidad que ha ido a dar clases o investigar en una universidad extranjera en el último año académico

7. Módulo clasificación de la universidad según opinión de expertos: a) a través de una encuesta los expertos determinan el puesto de las universidades extranjeras en un ranking.

Los datos obtenidos en estos apartados son evaluados por un grupo de expertos

que determinan cada uno por sí mismo, el peso de cada indicador dentro del

módulo y el peso de cada bloque en el conjunto. Usando el valor final de cada

indicador dentro de cada bloque, y de los bloques en el conjunto se determinó

el promedio de todas las evaluaciones individuales. En el caso de que las

ponderaciones de cada experto, se separaran en más de un 15%, se convocó una

reunión de expertos para consensuar la ponderación. Con base en las

ponderaciones, se sumó el valor de los indicadores en cada bloque, ordenándolos

de forma descendente, luego se le otorgó a la universidad del máximo valor 100

puntos y recalculando los puntos de las demás universidades en relación a este

valor máximo. Con base al valor de cada bloque, se suman los valores obtenidos

en cada uno ordenando las universidades de nuevo por orden descendente,

poniendo luego a la universidad del máximo valor 100 puntos y recalculando los

puntos de las demás universidades en relación a este valor máximo. Este

procedimiento permite establecer clasificaciones por bloque y para el conjunto

de los módulos.

Presentación

Los resultados de esta clasificación se presentan en forma de tabla, en la que las universidades están ordenadas por el valor obtenido en la evaluación global. En la misma tabla, se presentan también los resultados de la evaluación ponderada de cada bloque.

Tabla de las 100 mejores universidades globales del New

Global University Ranking

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras

universidades

Además, se presentan los resultados agregados por países determinando la cantidad de universidades de cada país en las listas de los mejores 100, 200, 300, 400 y 500.

Tabla del New Global University Ranking de la

clasificación de los países por número de universidades entre los 500 mejores

universidades

Nota: por razones de espacio se presenta aquí el recorte de los 10 primeros

países

También se presenta el ranking de las universidades del ámbito territorial de Rusia y de las republicas de la Comunidad de Estados Independientes (CEI – la organización supranacional que han constituido 15 estados de la antigua URSS después de su desaparición).

Tabla del New Global University Ranking de la

clasificación global de las universidades de Rusia, del CEI y de los países

bálticos

Nota: por razones de espacio se presenta aquí el recorte de las cinco primeras

universidades

Comentario

Se trata de un ranking multifactorial que pretende constituirse en alternativa a las clasificaciones de ARWU y THES ampliando el abanico de indicadores Los resultados de esta evaluación son muy diferentes a estas dos clasificaciones ordenadas, mejorando la posición de las universidades rusas y empeorando la posición de las universidades estadounidenses.

En los diferentes módulos se definen algunos indicadores de forma poco precisa, como p.ej. en el módulo 1 el de ganadores de competiciones académicas internacionales de estudiantes desde 2001; o en el módulo 2 el de número de premios mundiales recibidos por parte del personal académico de la universidad. También en el módulo 3 del prestigio científico, se definen los indicadores sin mencionar cuales son las fuentes de información. Caben dudas sobre si todas las administraciones universitarias dispongan realmente de datos sobre todas las publicaciones de su personal académico. Tampoco se especifica cómo se determina cual es la fuente para establecer el promedio de citas y referencias de la publicación del personal académico por parte de autores extranjeros en el último año académico.

Como en el THES-Ranking, hay algunas dudas sobre la transparencia y el valor de la encuesta entre expertos que votan por el prestigio de las universidades extranjeras. No se define claramente quién es considerado experto, ni se expone información sobre la población encuestada y el retorno de las respuestas.

Se explica cómo se establece el esquema de la ponderación, pero no el peso de cada indicador. Tampoco se representa el valor que ha obtenido una universidad en cada uno de los módulos sino su posición en el ranking singular.

FICHA 4: Institutional Ranking World Report

Observación

El SCImago Institutional Ranking World Report (SIR) es accesible a través de la página Web de la entidad autora SCImago. El enlace se ha establecido al elaborar este artículo. En esta Web pueden bajarse las sucesivas versiones de la clasificación institucional bibliométrica que se actualiza cuando se incorporan nuevos datos. Las versiones están numeradas por año y número de edición anual. El documento usado aquí tiene el indicador 2009/002.

A través de una noticia en una revista electrónica, se puede acceder, además, a otros dos documentos sobre este ranking. Los datos presentados en estas dos publicaciones no coinciden con los datos de la versión oficial, debido a que no se basan en las publicaciones autorizadas, sino en información no-autorizada.

Objetivo

EL SIR es elaborado por SCImago [www.scimago.es], un grupo de investigación compuesto por investigadores de universidades españolas y portuguesas y del Instituto de Políticas y Bienes Públicos (IPP) del CSIC español. El SIR es una clasificación del rendimiento investigador de más de 2000 instituciones de investigación con base en el análisis de publicaciones y citas en revistas científicas incluidas en la base de datos Scopus de Elsevier. En la lista se incluyen instituciones de 84 países de los cinco continentes. Las instituciones se clasifican en cinco grupos: gubernamental, educación superior, salud, corporativo y otros.

Metodología

Se trata de una metodología bibliométrica que utiliza exclusivamente la base de datos Scopus. Previamente se definen 5 indicadores del rendimiento investigador:

a) Output medido por el número de documentos publicados en las revistas científicas incluidas en la base de datos. Este indicador está influido, entre otros factores, por el tamaño de la institución y el perfil investigador

b) Citas por documento muestra el impacto científico de las publicaciones de una institución. El valor de este indicador expresa el promedio de citas de los documentos publicados por una institución en el período de referencia. Este valor está influido por el perfil investigador de la institución.

c) Colaboración internacional muestra el grado de colaboración con otras instituciones extranjeras para la publicación de documentos. Se calcula el valor del indicador por las publicaciones de la institución en que investigadores de instituciones extranjeras comparten la autoria.

d) SJR-index normalizado muestra el valor promedio de una revista en la que la institución ha publicado un documento. El SRJ índex es el producto de otro proyecto de evaluación de revistas realizados por SCImago utilizando la base de datos de Scopus. Un valor por encima de 1 indica que la institución ha publicado la mayor parte de sus documentos en revistas cuya relevancia en el campo científico está encima del promedio. Un valor por debajo de 1 indica que la institución ha publicado la mayor parte de sus documentos en revistas cuya relevancia en el campo científico está por debajo del promedio.

e) Puntuación de citas normalizado por campo muestra la tasa entre el promedio del impacto científico de una institución y el promedio del impacto mundial de las publicaciones en el mismo período de tiempo y en la misma área de conocimiento. Se usa la metodología propuesta por el Karolinska Institutet (Suecia) denominada “item oriented field normalized citation score average”, que se calcula normalizando la tasa de cada publicación individual frente a la tasa promedio de citas de los artículos en la misma área de conocimiento. Los valores están presentados en forma de porcentaje, teniendo como referencia el valor 1 que expresa que las publicaciones del instituto están citadas por igual que el promedio de los artículos en la misma área de conocimiento. Un valor de 0,8 significa que su tasa está 20% por debajo del promedio mundial y 1.3 significa que su tasa está 30% por encima del promedio mundial en la misma área del conocimiento.

Presentación

El ranking incluye más de 2000 instituciones ordenadas de forma descendente según el valor obtenido en el ámbito del “output”.

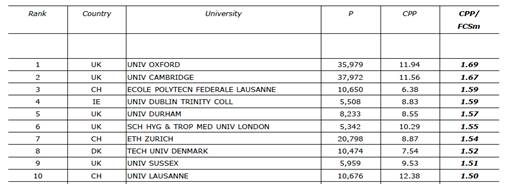

Tabla de la clasificación de las universidades y centros de

investigación

del Institutional Ranking World Report

Nota: por razones de espacio se presenta aquí el recorte de las diez primeras

universidades

Comentario

Dado que no somos expertos en ciencias de documentación, aquí no entramos en la valoración de la selección de los indicadores. Sin embargo, se puede insistir en la crítica ya formulada en los comentarios a otros rankings: que una clasificación por instituciones aporta poca información añadida para mejorar las actuaciones de las mismas o de las facultades o departamentos. Para que un ranking bibliométrico tuviera incidencia en la actuación de las instituciones debería enfocarse en las facultades, departamentos o los centros especializados de las universidades o de las instituciones de investigación.

Ésta, como otras clasificaciones bibliométricas, enfoca el sistema científico tradicional, edonde el prestigio científico se mide a través de las publicaciones. La interconexión del sistema científico con otros sistemas sociales como la economía, la política y la sociedad queda intencionadamente excluido de este tipo de rankings.

Dentro del contexto del sistema de publicaciones científicas parece razonable la decisión de los promotores de este ranking de incluir otras instituciones en el mismo además de las instituciones de educación superior. De este modo se cubren las diferentes partes de los sistemas de investigación científica y su aportación a la producción científica en formato de artículos.

FICHA 5: Performance Ranking of Scientific Papers of World Universities

<http://ranking.heeact.edu.tw/en-us/2009%20by%20Fields/Domain/SOC/TOP/100>

Objetivo

El Performance Ranking of Scientific Papers of World Universities (Performance Ranking) del Higher Education Evaluation & Accreditation Council of Taiwan se centra en la evaluación de los documentos científicos de 500 universidades mundiales, midiendo el rendimiento investigador de estas universidades. Utilizando los documentos (artículos etc.) científicos, se pretende crear indicadores más objetivos comparados con los que estén basados en la obtención de premios o en encuestas sobre el prestigio o la reputación científica de las universidades, que en principio favorecen a las que tienen más tradición e historia. Se trata, por lo tanto, de una clasificación bibliométrica del rendimiento investigador de las universidades.

Metodología

Para evaluar el rendimiento científico en publicaciones se usan datos cuantitativos procedentes de Thomson Reuters como el Essential Science Indicators (ESI), la WEB of Science, que incluye el Index de Citaciones de Ciencias (Science Citation Index SCI), el Index de Citaciones de Ciencias Sociales (Social Science Citation Index - SSCI), y el Journal Citation Report. Las herramientas más importantes son el SCI y el SSCI, suponiendo que la forma dominante que adquieren los resultados científicos son publicaciones en revistas académicas. Este ranking excluye del procedimiento el indicador de citas en Artes y Humanidades (Arts & Humanities Citation Index A&HCI) porque en estas áreas los investigadores publican gran parte de su trabajo en su propio idioma mientras que el A&HCI incluye sobre todo publicaciones en inglés.