Antonio Eleazar Serrano-López

Departamento de Biblioteconomía y Documentación

Universidad Carlos III de Madrid

Saenen, Bregt; Morais, Rita; Gaillard, Vinciane; Borrell-Damián, Lidia (2019). Research assessment in the transition to open science: 2019 EUA open science and access survey results. Brussels; Geneva: European University Association. 47 p. Disponible en: <https://www.eua.eu/resources/publications/888:research-assessment-in-the-transition-to-open-science.html?utm_source=social&utm_medium=Twitter&utm_name=Twitter-social-22-10-2019>. [Consulta: 20/11/2020].

Desde hace algún tiempo, asistimos a un proceso de cambio en las políticas de evaluación de la actividad científica, que trata de adaptarse a los nuevos escenarios que se plantean, así como a las nuevas alternativas en cuanto a indicadores y fuentes para la evaluación. En este sentido, la implementación de la Ciencia Abierta es uno de los mayores retos a los que se enfrentan los decisores y los órganos de gobierno de universidades e instituciones nacionales y supranacionales.

Desde hace algún tiempo, asistimos a un proceso de cambio en las políticas de evaluación de la actividad científica, que trata de adaptarse a los nuevos escenarios que se plantean, así como a las nuevas alternativas en cuanto a indicadores y fuentes para la evaluación. En este sentido, la implementación de la Ciencia Abierta es uno de los mayores retos a los que se enfrentan los decisores y los órganos de gobierno de universidades e instituciones nacionales y supranacionales.

El informe de la European University Association (EUA) trata de hacer un diagnóstico de la situación actual y de la dirección que están tomando los órganos de gobierno de las universidades europeas de cara a la implementación de la Ciencia Abierta en sus políticas de evaluación de la actividad investigadora. Para ello, analiza los resultados de la encuesta Open science and access survey on research assessment, llevada a cabo en 2019 a diferentes órganos de gobierno dentro de las universidades europeas (rectorados, vicerrectorados, decanatos y direcciones de departamento).

Esta encuesta se viene realizando de manera anual por parte de la EUA desde 2014, aunque el número de respuestas obtenidas ha decaído notablemente desde que en 2016 alcanzaran su mayor tasa de respuesta (338 respuestas de universidades de 39 países), mientras que los resultados del presente informe se limitan a 260 respuestas de 32 países diferentes. Por otro lado, la tasa de respuestas por países también resulta muy irregular. Tanto es así que, en algunas de las respuestas, los datos de Turquía han sido tratados por separado, debido a que suponen un alto porcentaje del total de respuestas (35,7 %). A pesar de ello, los resultados obtenidos son bastante representativos de la situación actual, así como de la incertidumbre que están experimentando los decisores dentro de las universidades respecto a las futuras políticas de evaluación y al papel que debe jugar en ellas la Ciencia Abierta.

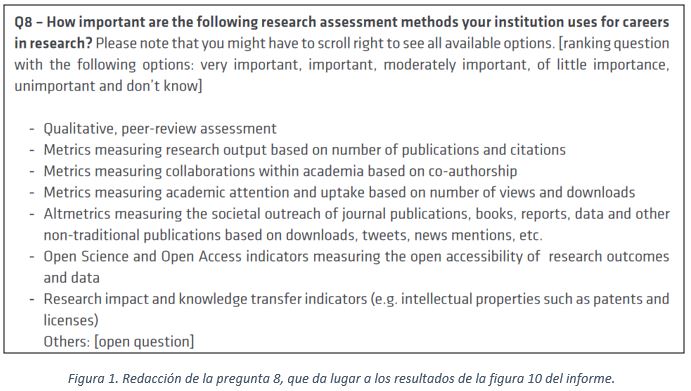

En este sentido, las respuestas reflejan que Ciencia Abierta y Acceso Abierto todavía no se consideran como una parte esencial del trabajo de investigación y, mientras que esta percepción no cambie, no podrán pasar a formar parte efectiva de las tareas que realizamos los investigadores. Esto se puede observar en el informe tanto en la figura 9 (pág. 21), sobre las tareas que se consideran parte esencial del trabajo de investigación, como en la figura 10 (pág. 23), sobre los métodos de evaluación de la actividad investigadora.

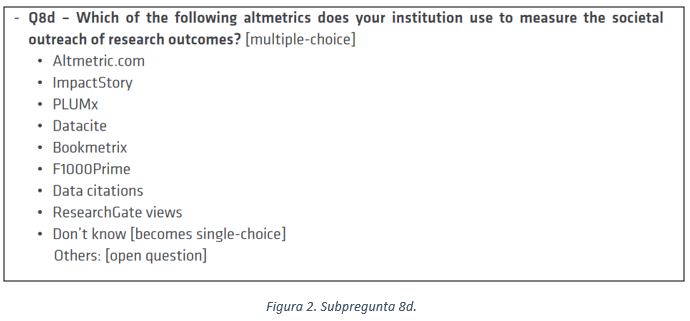

Asimismo, los resultados de esta última pregunta llaman la atención sobre otros aspectos emergentes de la evaluación, especialmente al comprobar que el uso de indicadores altmétricos, cuya validez aún está por demostrar, se sitúa muy cerca de la accesibilidad de las publicaciones y los datos de investigación a través de la Ciencia Abierta, estando esta premisa mucho más asentada en la comunidad científica. Además, los indicadores altmétricos se sitúan, a su vez, por encima de métricas alternativas, pero más cercanas al ámbito académico, como son las views o las descargas de las publicaciones, siendo estas medidas mucho más cercanas a la comunidad científica y mostrando una mayor correlación con la citación como medida de uso de las publicaciones. En cualquier caso, los resultados de esta pregunta deberían ser analizados cuidadosamente, ya que la redacción de la pregunta (figura 1) puede resultar problemática, al existir solapamiento entre dos de las categorías (altmetrics y academic attention), pues ambas incluyen las descargas como indicador y puede haber generado confusión en las respuestas.

Por otro lado, las respuestas sobre los indicadores de evaluación incluidas en las políticas de cada universidad muestran una tendencia hacia la utilización de los indicadores más tradicionales, a pesar de que muchos de ellos han mostrado sesgos y problemas metodológicos importantes, especialmente en el caso de la evaluación a nivel de investigador (factor de impacto, índice H, etc.).

Sin embargo, el mayor problema detectado a través de esta encuesta reside en el hecho de que las políticas de evaluación en la mayoría de las universidades sólo reconocen influencias de la propia universidad o de otras universidades, mientras apenas existen centros que reconozcan verse influidos por los manifiestos más importantes al respecto, como el Manifiesto de Leiden, DORA (San Francisco Declaration on Research Assessment) o Metric Tide (figura 14, pág. 29), si bien indican que los están teniendo en cuenta a la hora de elaborar sus futuras políticas de evaluación, por lo que parece los principios por estos documentos comienzan a permear en las políticas de evaluación, aunque hayan tardado varios años en hacerlo (DORA se publicó en 2012 y Metric Tide y el Manifiesto de Leiden en 2015).

Por último, y como reflexión final sobre los problemas en la elaboración de políticas de evaluación, llama enormemente la atención que solo el 26 % de las universidades encuestadas señalan como un problema la falta de alineación entre las políticas nacionales, supranacionales y universitarias, cuando este problema es mucho más real para los investigadores, que se encuentran elaborando diferentes versiones de sus curricula y buscando evidencias de la calidad de su actividad científica en infinidad de formatos, fuentes y sistemas de evaluación, cada uno diferentes y con criterios de lo más dispares, aunque no parece que esto suponga un problema para los órganos de gobierno de las universidades.